作者:微信小助手

发布时间:2025-03-17T11:56:19

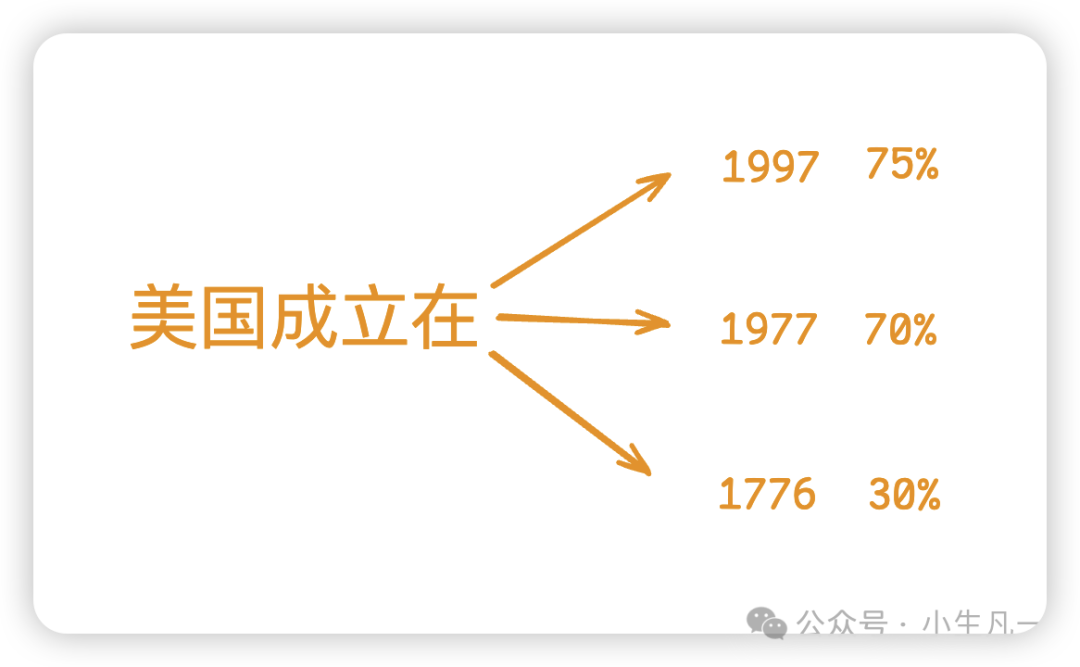

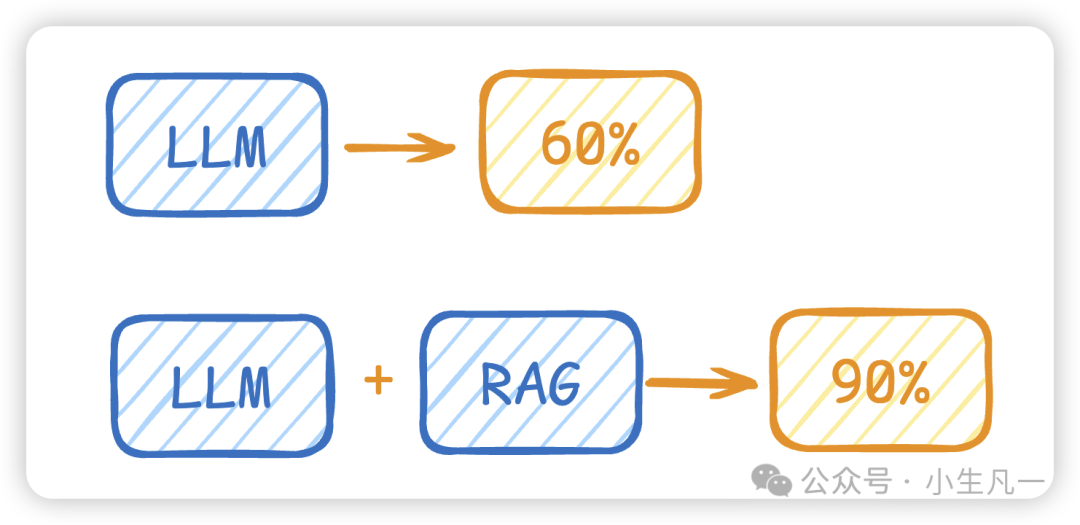

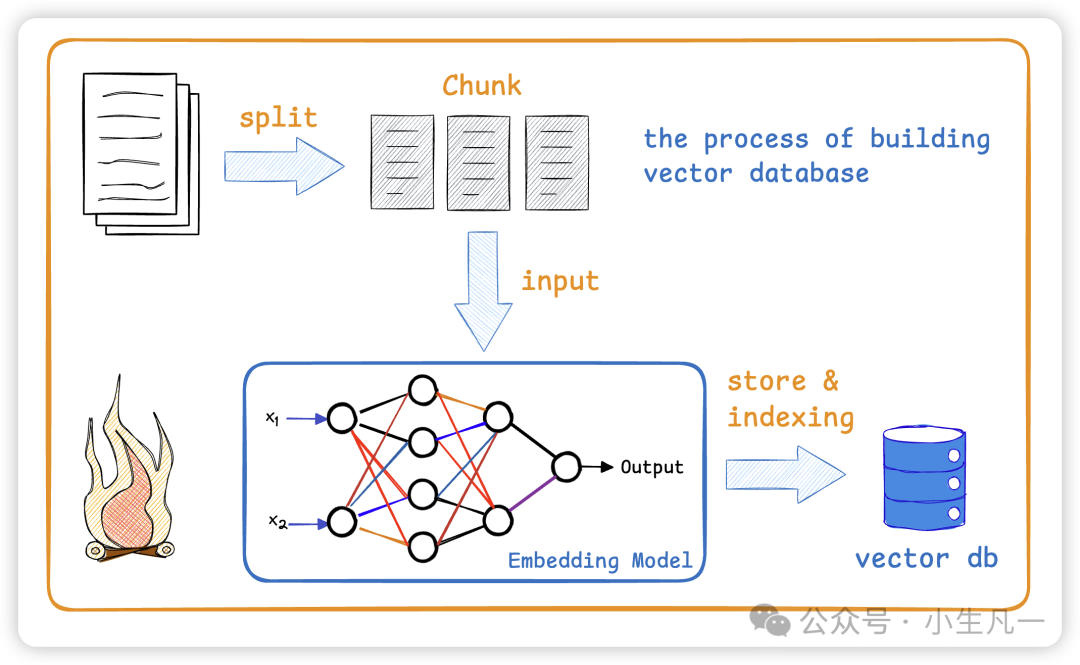

在讲RAG之前,我们先说一个大模型的普遍现象,大家应该都用过大模型了,比如 ChatGPT、DeepSeek、豆包、文心一言等等… 那么大家在用的时候其实会发现,有时候大模型会乱回答,一本正经地胡说八道,语义不同,前言不搭后语。 举个例子:你问大模型,美国成立时间。大模型可能会回答:美国成立在1997年,距离现在已有400年的历史… 这种现象叫hallucination,幻觉。大模型本质的就是不断的预测下一个生成的文字应该是什么,而选择预测概率中最大的一个。 产生幻觉的原因有很多, 而我们要说的RAG就是 RAG(Retrieval-Augmented Generation,检索增强生成) 核心原理为 这样说可能比较生硬,打个比方:LLM在考试的时候面对陌生的领域,只会写一个解字(因为LLM也只是局限于特定的数据集进行训练),然后就准备放飞自我了,而此时RAG给了亿些提示,让LLM懂了开始往这个提示的方向做,最终考试的正确率从60%到了90%! 简单来说就是大家的 为什么是向量数据库?传统数据库为啥不行? 向量数据库是通过存储 如果使用传统数据库(如MySQL)结合关键词检索,但无法实现语义理解,可能导致漏检或误检。 举个例子,同一个query进行搜索:“2024年腾讯的技术创新”。 我们先明白 回到最开头的例子: 这样就 那么向量数据库如何构造呢? 那这里为什么要进行chunking呢? chunking是为了把相同语义的 token 聚集在一起,不同语义的 token 互相分开,在长文档中各个片段的语义可能存在较大差异,如果将整个文档作为一个整体进行知识检索,会导致语义杂揉,影响检索效果。 将长文档切分成多个小块,可以使得每个小块内部表意一致,块之间表意存在多样性,从而更充分地发挥知识检索的作用。 所以如果我们的块太小会导致错过真正的相关内容,太大则可能导致搜索结果不准确 [1] https://aws.amazon.com/what-is/retrieval-augmented-generation/ [2] https://blog.csdn.net/2301_78285120/article/details/144360003写在前面

比如训练大模型本身的数据问题、过拟合、微调引起的知识丧失、推理机制的不完善等等…为了降低大模型出现幻觉的概率,下面开始我们今天的主题。RAG简介

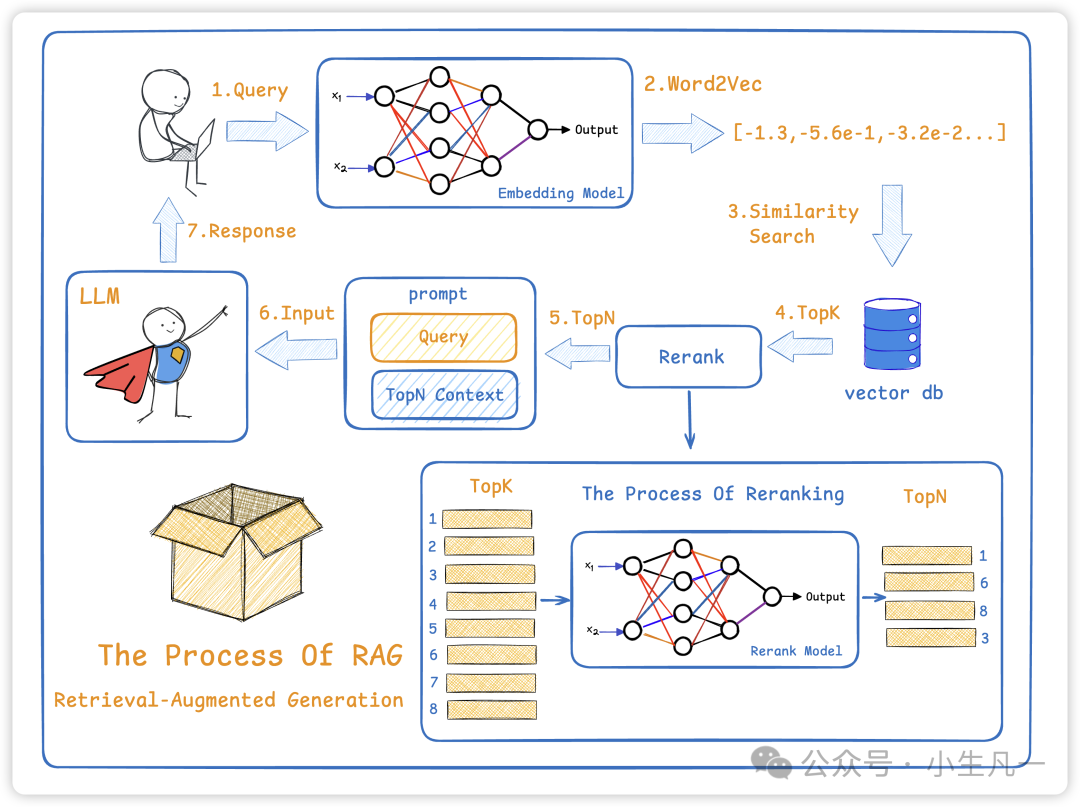

是一种结合信息检索与文本生成的技术,旨在提升大语言模型在回答专业问题时的准确性和可靠性。

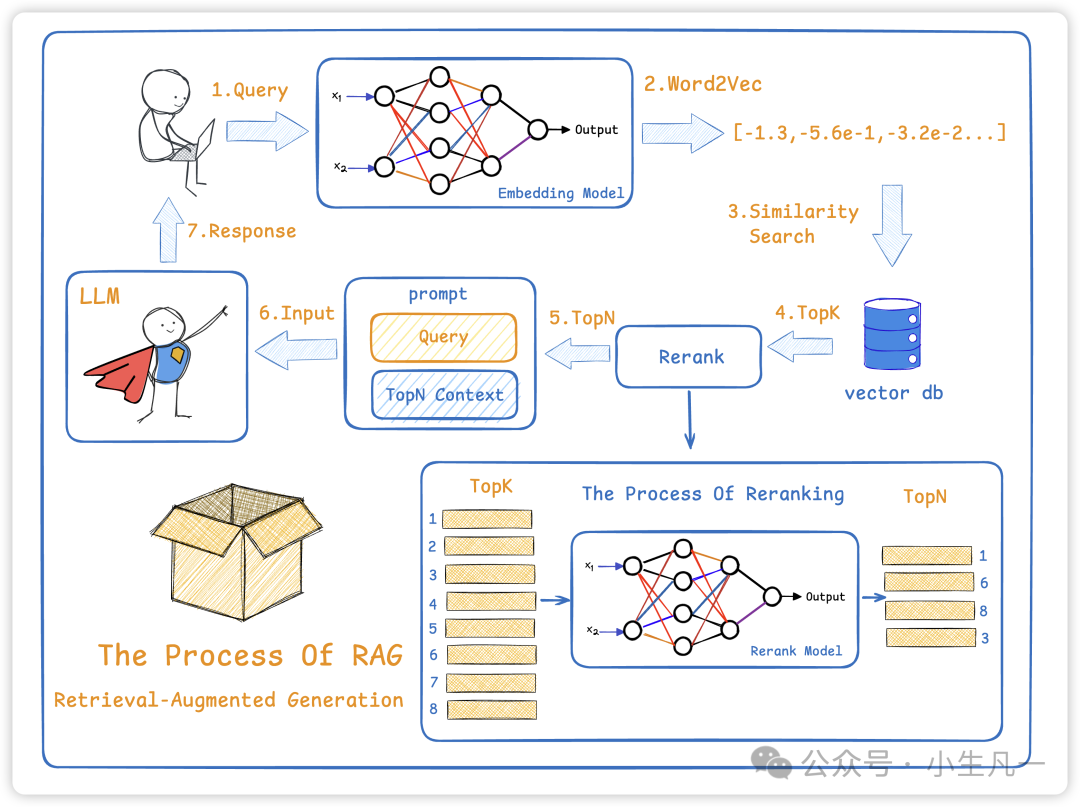

检索 + 生成 两阶段流程 :

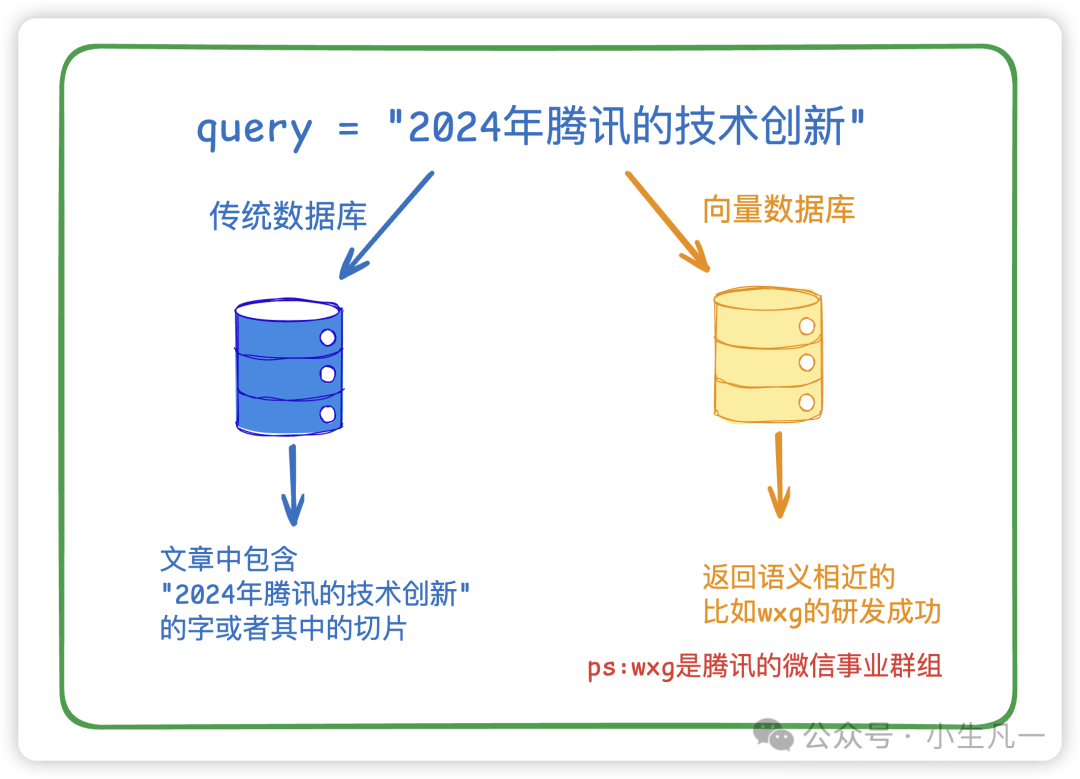

开卷考试!!那么问题来了,LLM开卷考试的话,这个卷是啥呢?这里就涉及到向量数据库了。向量数据库

文本的向量化表示,支持基于语义相似度的快速检索, 解决了传统关键词匹配无法捕捉上下文关联的问题。

那向量数据库是怎么知道语义相似的?

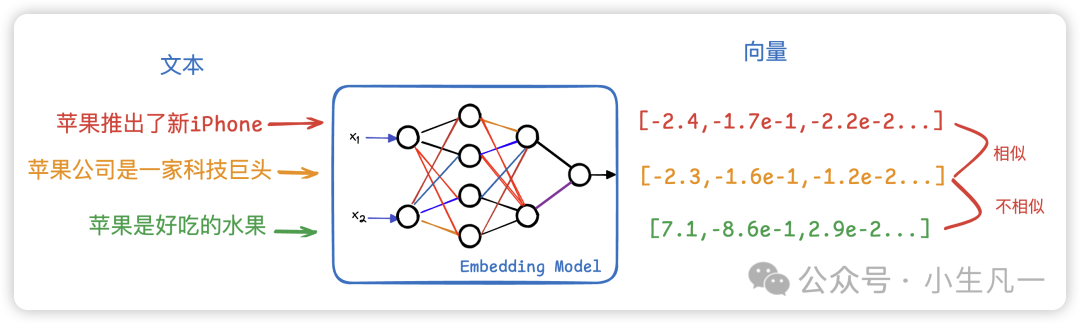

那向量数据库是怎么知道语义相似的?向量数据库存储的是向量,不是文本,文本是大家能看懂的文字,而向量是一串浮点型数据。那么当所有的文本都成了浮点型数据后,计算机可以通过数学公式(比如余弦相似度),量化语义相似性。 传统数据库用原始文本检索,则无法处理同义词、多义词、语境差异等语义问题(例如“苹果”可能指水果或公司),所以很多传统搜索都会进行query改写这一步,来让搜索的输入query更精确。当然不仅仅是文本,

传统数据库用原始文本检索,则无法处理同义词、多义词、语境差异等语义问题(例如“苹果”可能指水果或公司),所以很多传统搜索都会进行query改写这一步,来让搜索的输入query更精确。当然不仅仅是文本,万物皆可embedding,图片、videos、音频等等…RAG 过程

可以有效的控制大模型输出尽可能的相关并且语义相通的内容。 其实很简单:

其实很简单:

参考