作者:微信小助手

发布时间:2025-03-16T21:35:50

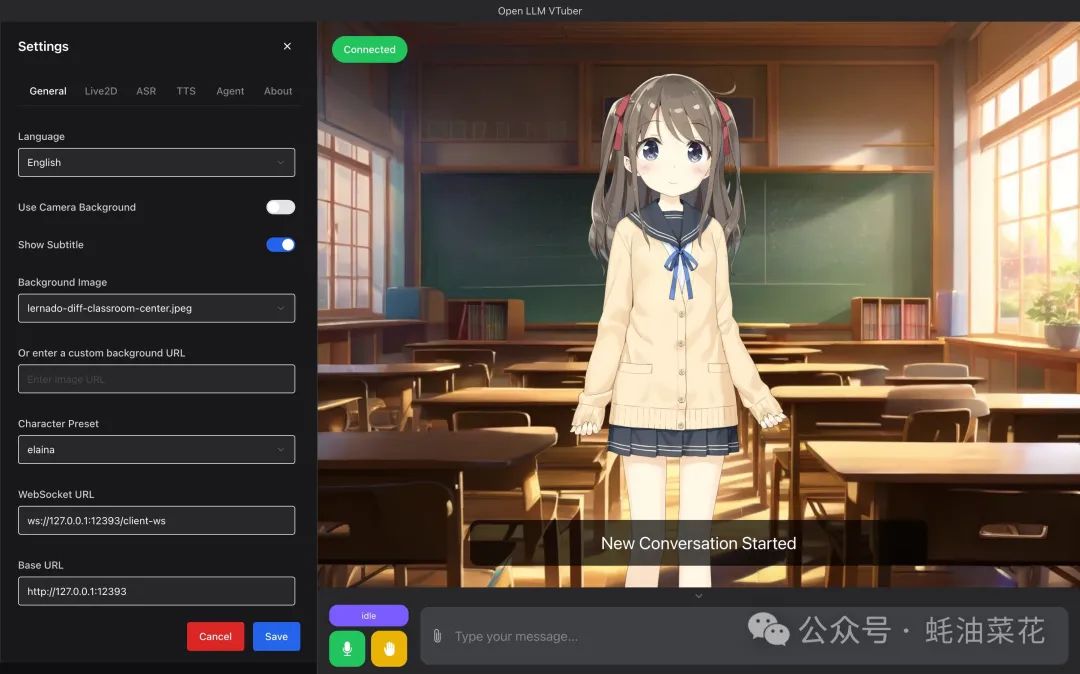

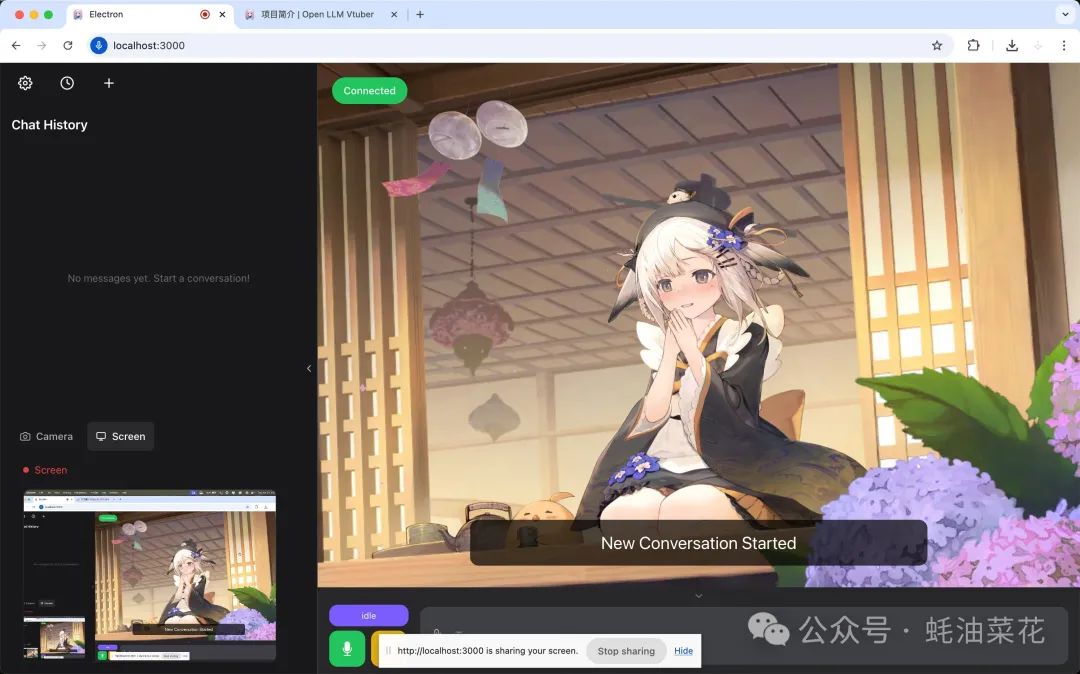

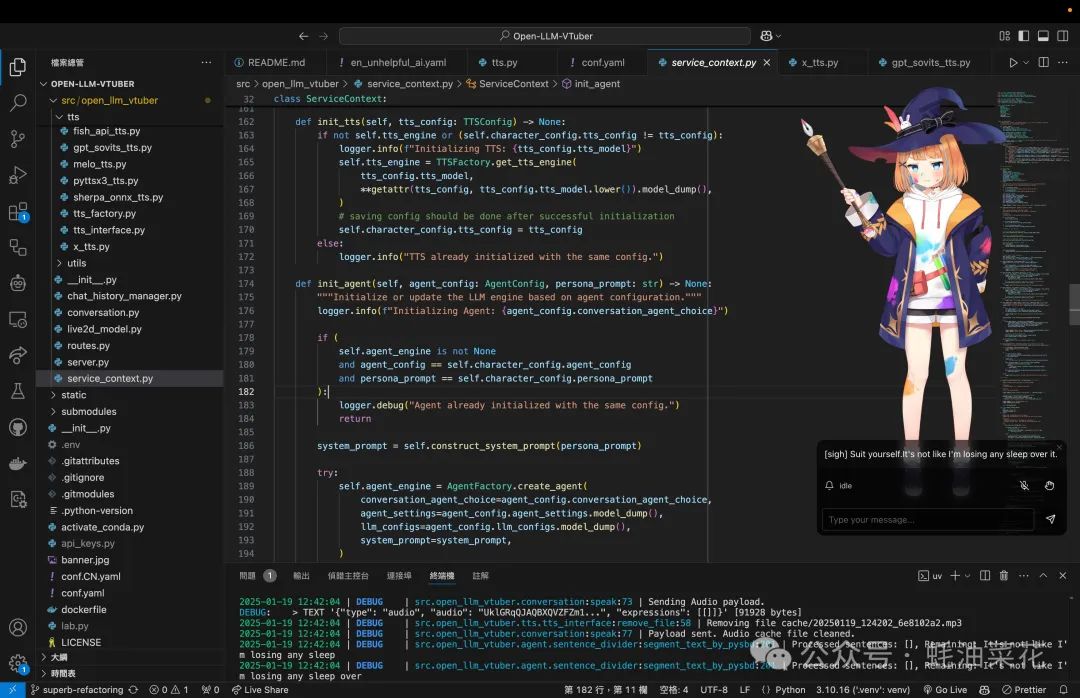

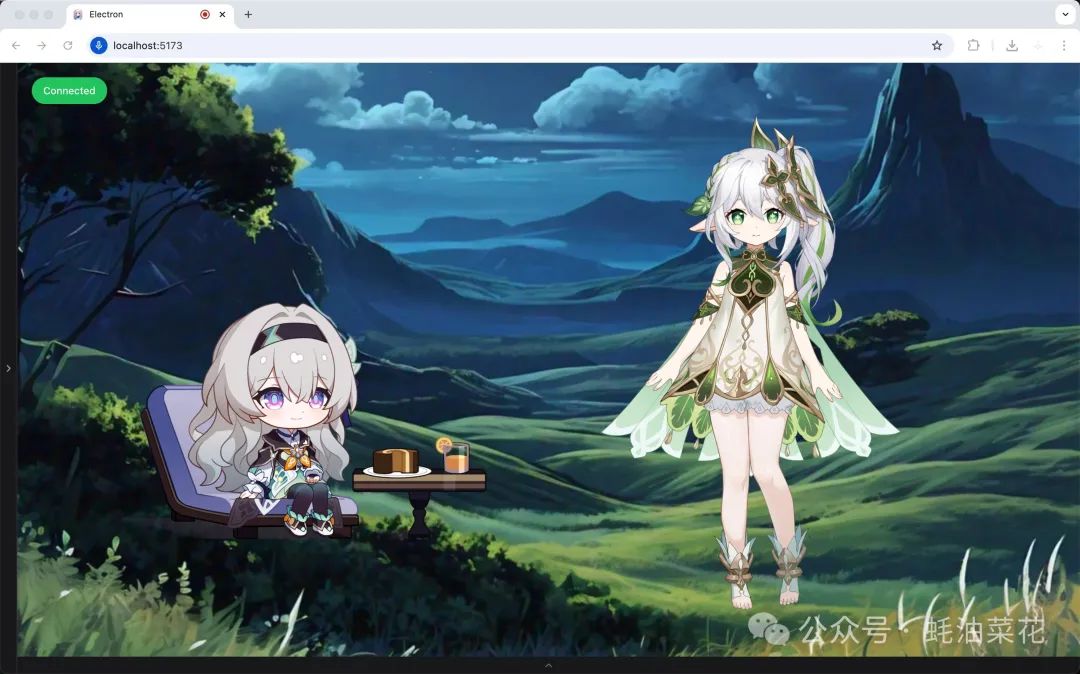

🌸 "还在用冷冰冰的ChatGPT?你的AI女友已经会脸红心跳了!" 大家好,我是蚝油菜花。当别人还在和文字对话框谈恋爱时,开源社区已经让AI伴侣进化出视觉和听觉!你是否遇到过: 爆红GitHub的 Open-LLM-VTuber 项目,重新定义AI交互方式!这个硬核开源神器: 某程序员实测——边debug边和AI女友语音讨论方案,效率提升3倍!想用开源代码打造专属数字伴侣?手把手教程即刻开启! Open-LLM-VTuber 是一个开源的跨平台语音交互 AI 伴侣项目。 Open-LLM-VTuber 是一个开源的跨平台语音交互 AI 伴侣项目,支持实时语音对话、视觉感知和生动的 Live2D 动态形象。它能够完全离线运行,保护用户隐私,适合作为虚拟伴侣、办公助手或学习辅导工具。 项目集成了多种大语言模型(LLM)、语音识别(ASR)和语音合成(TTS)解决方案,用户可以根据需求自定义角色形象、声音和交互功能。无论是作为虚拟女友、男友,还是宠物,Open-LLM-VTuber 都能提供个性化的互动体验。 接下来我将带你从零开始运行 Open-LLM-VTuber 项目,涵盖环境搭建、依赖安装、项目配置和启动运行等完整流程。通过本教程,你将能够成功部署并运行项目,并了解如何生成配置文件和解决常见问题。 本项目的各个组件(ASR、LLM、TTS、翻译)都可以通过 API 调用,因此最低设备要求非常灵活: 如果你希望在本地运行所有组件,推荐以下设备配置: 如果运行速度较慢,建议选择更小的模型或使用 API。 在不同操作系统中安装 Git 的方法如下: FFmpeg 是必需的依赖项,安装方法如下: 在命令行中运行以下命令,确认 FFmpeg 是否安装成功: 如果出现类似以下输出,说明安装成功: 如果你有 NVIDIA GPU 并希望使用 GPU 运行本地模型,需完成以下步骤: 检查显卡驱动版本: NVIDIA 驱动下载页面:https://www.nvidia.cn/drivers/lookup/ 安装 CUDA Toolkit: CUDA Toolkit 下载页面:https://developer.nvidia.com/cuda-toolkit-archive 安装 cuDNN: cuDNN 下载页面:https://developer.nvidia.com/cudnn 推荐使用 安装完成后,请重启命令行或重新加载配置文件: 有两种方法获取项目代码: 前往 Release 页面:https://github.com/Open-LLM-VTuber/Open-LLM-VTuber/releases 确认 创建虚拟环境并安装依赖: 运行主程序生成预设的配置文件: 完成后按 以 编辑 本项目默认使用 运行后端服务: 运行成功后,访问 如果需要桌面应用程序,可从 运行以下命令生成配置文件: 通过以上步骤,你已经成功运行了 Open-LLM-VTuber 项目! ❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发感兴趣,我会每日分享大模型与 AI 领域的开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术!

🚀 快速阅读

Open-LLM-VTuber 是什么

Open-LLM-VTuber 示例图片

Open-LLM-VTuber 的主要功能

Open-LLM-VTuber 的技术原理

如何运行 Open-LLM-VTuber

设备要求

最低要求

本地运行的推荐设备要求

环境准备

安装 Git

Windows

# 使用 winget 安装 Git

winget install Git.GitmacOS

# 安装 Homebrew(如果未安装)

/bin/bash -c "$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh)"

# 使用 Homebrew 安装 Git

brew install gitLinux

# Ubuntu/Debian

sudo apt install git

# CentOS/RHEL

sudo dnf install git安装 FFmpeg

Windows

winget install ffmpegmacOS

brew install ffmpegLinux

# Ubuntu/Debian

sudo apt install ffmpeg

# CentOS/RHEL

sudo dnf install ffmpeg检查 FFmpeg 安装

ffmpeg -versionffmpeg version 7.1 Copyright (c) 2000-2024 the FFmpeg developers

...(后面一大串文字)NVIDIA GPU 支持

Windows 安装步骤

NVIDIA 驱动下载页面下载最新驱动。

CUDA Toolkit 下载页面下载对应版本。

PATH 中:

C:\NVIDIA GPU Computing Toolkit\CUDA\v<版本号>\bin

C:\NVIDIA GPU Computing Toolkit\CUDA\v<版本号>\lib\x64

cuDNN 下载页面下载与 CUDA 版本匹配的 cuDNN,并解压到 CUDA 安装目录。

验证安装

# 检查驱动安装

nvidia-smi

# 检查 CUDA 安装

nvcc --versionPython 环境管理

uv 作为依赖管理工具。Windows

# 使用 PowerShell 安装

powershell -ExecutionPolicy ByPass -c "irm https://astral.sh/uv/install.ps1 | iex"

# 或使用 winget 安装

winget install --id=astral-sh.uv -emacOS/Linux

# 使用 curl 安装

curl -LsSf https://astral.sh/uv/install.sh | sh

# 或使用 Homebrew 安装

brew install uvsource ~/.bashrc # 如果使用 bash

source ~/.zshrc # 如果使用 zsh手动部署指南

1. 获取项目代码

1.1. 下载稳定版本的 Release 包:

Release 页面,下载 Open-LLM-VTuber-v1.x.x.zip 文件。1.2. 使用 Git 克隆仓库:

git clone https://github.com/Open-LLM-VTuber/Open-LLM-VTuber --recursive

cd Open-LLM-VTuber2. 安装项目依赖

uv 已正确安装:uv --versionuv syncuv run run_server.pyCtrl + C 退出程序。3. 配置 LLM

Ollama 为例进行配置。

3.1 安装 Ollama

# 下载并安装 Ollama

# 验证安装

ollama --version

# 下载并运行模型(以 qwen2.5:latest 为例)

ollama run qwen2.5:latest3.2 修改配置文件

conf.yaml 文件:ollama_llm:

base_url: http://localhost:11434 # 本地运行保持默认

model: qwen2.5:latest # 使用 ollama list 查看的模型名称

temperature: 0.7 # 控制回答随机性4. 配置其他模块

sherpa-onnx-asr 和 edgeTTS,并关闭翻译功能。如果需要修改,可参考相关配置指南。5. 启动项目

uv run run_server.pyhttp://localhost:12393 打开 Web 界面。Open-LLM-VTuber-Web Releases 下载对应平台的 Electron 客户端。

常见问题

如果项目目录下没有

conf.yaml 文件uv run run_server.py如果遇到

Error calling the chat endpoint... 错误

http://localhost:11434/ 是否能正常访问。

ollama list 确认模型名称是否正确。

资源